Data driven design a optymalizacja energetyczna

Jakie możliwości dają dziś projektantom technologie cyfrowe?

W dobie rosnącej świadomości ekologicznej projektowanie parametryczne, generatywne, algorytmiczne staje się nie tylko metodyką ambitnych projektantów, lecz także narzędziem pozwalającym uzyskać odpowiedzi w obszarach, gdzie jedynie skomplikowana analiza wielokryterialna pozwoli na uzyskanie miarodajnych, kompleksowych wyników.

Filozofia stojąca za projektowaniem parametrycznym

. Kluczowi pionierzy i ich wkład w rozwój koncepcji Projektowanie parametryczne jako proces jednoczesnej analizy wielu parametrów i ich wpływu na efekt końcowy odbywało się w głowach projektantów od zawsze. Wystarczy przywołać eksperymenty Antonio Gaudiego, który często uważany jest za pioniera projektowania parametrycznego, mimo że termin ten nie był używany w jego czasach. Gaudi stosował techniki, które współcześnie klasyfikowalibyśmy jako parametryczne do tworzenia złożonych, organicznie wyglądających struktur. Jego metody projektowania opierały się na obserwacji natury i matematycznych zasad w niej zawartych i mogą być uważane za wczesną formę myślenia parametrycznego. Podobne podejście (bazujące na eksploracji matematycznych zasad do odnajdywania nowych, optymalnych form konstrukcyjnych) prezentował Buckminster Fuller czy też Frei Otto. Buckminster Fuller i jego koncepcja „Doing more with less” zainspirowała pokolenia projektantów do poszukiwania takich rozwiązań konstrukcyjnych i materiałowych, które umożliwią uzyskanie wysokiej optymalizacji parametru zużycia materiałów w relacji do zachowanych możliwości konstrukcyjnych. Fuller pokazał, że dzięki zastosowaniu zasad geometrii można osiągnąć struktury o wysokiej wytrzymałości, przy jednoczesnym znacznym obniżeniu zużycia materiałów. Z kolei Frei Otto zasłynął z przeprowadzenia badań nad formami i strukturami znalezionymi w naturze, takimi jak: pajęcze sieci, bańki mydlane, struktury kostne i naśladowania zasad, na jakich działają w projektach lekkich konstrukcji i dachów w formie membran. Prace Ottona pokazały, w jaki sposób projektowanie może skorzystać z matematycznych i fizycznych prawidłowości w celu stworzenia bardziej efektywnych i zrównoważonych rozwiązań architektonicznych.

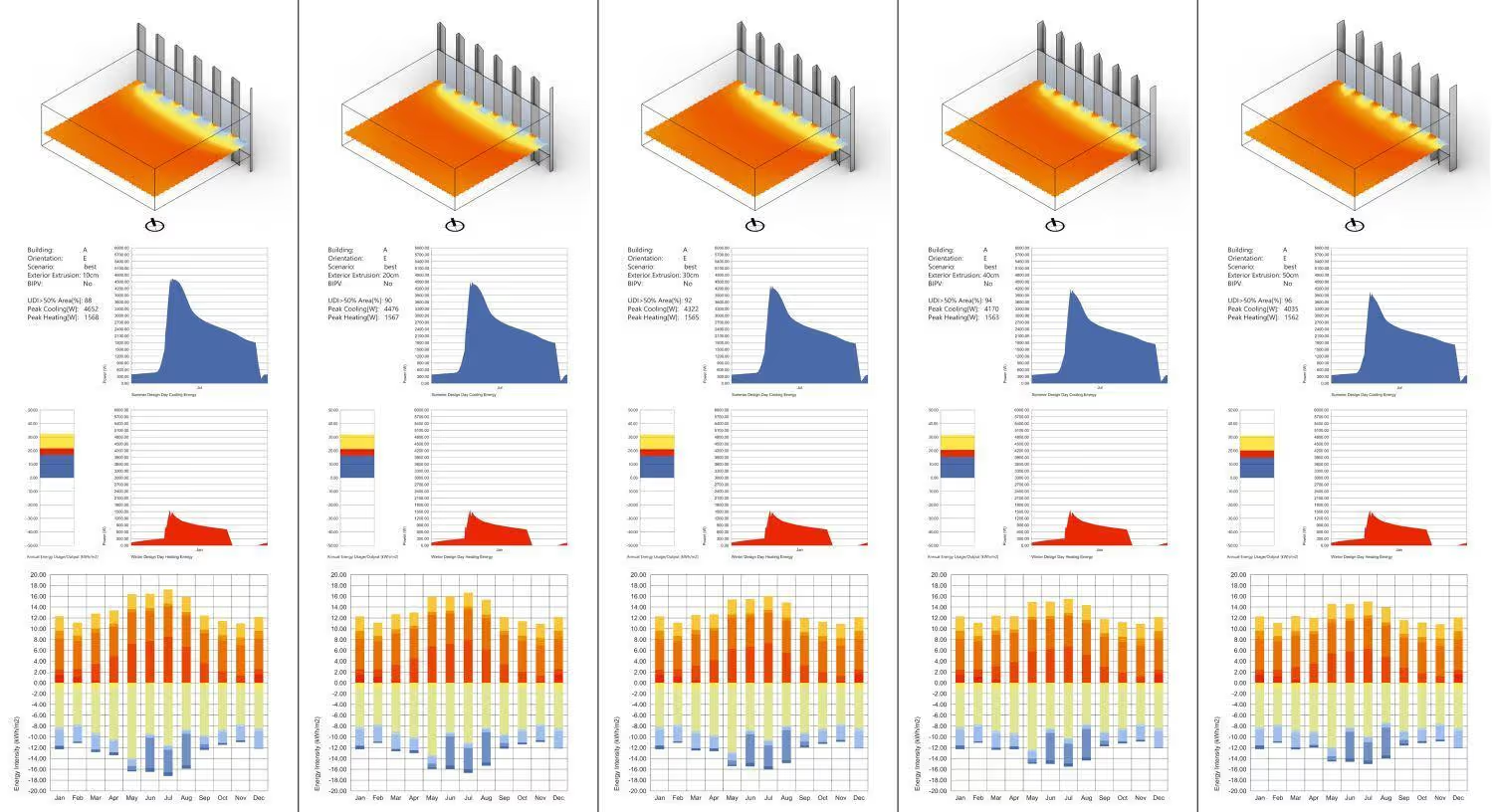

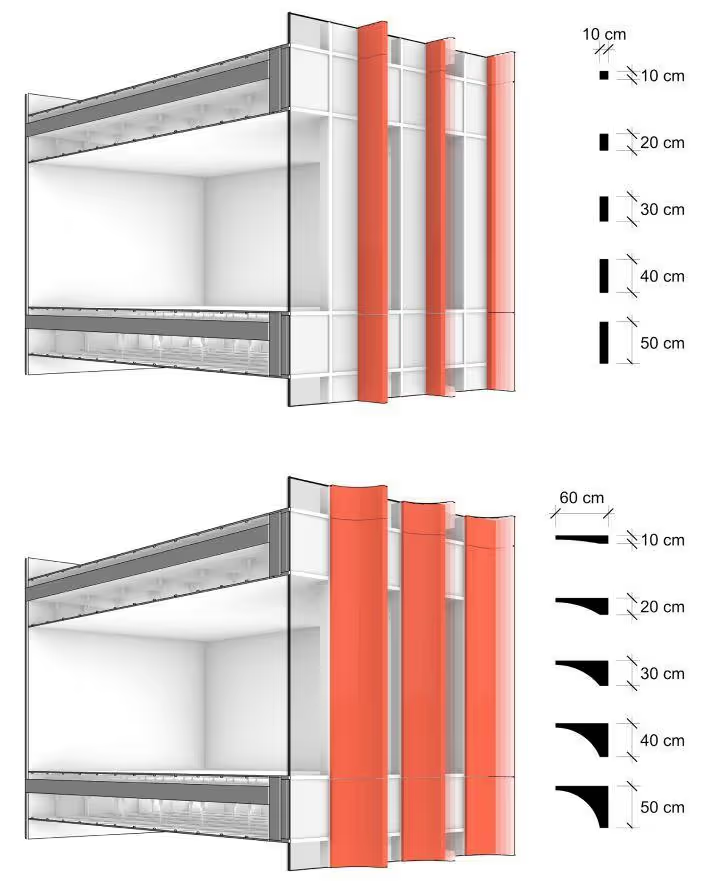

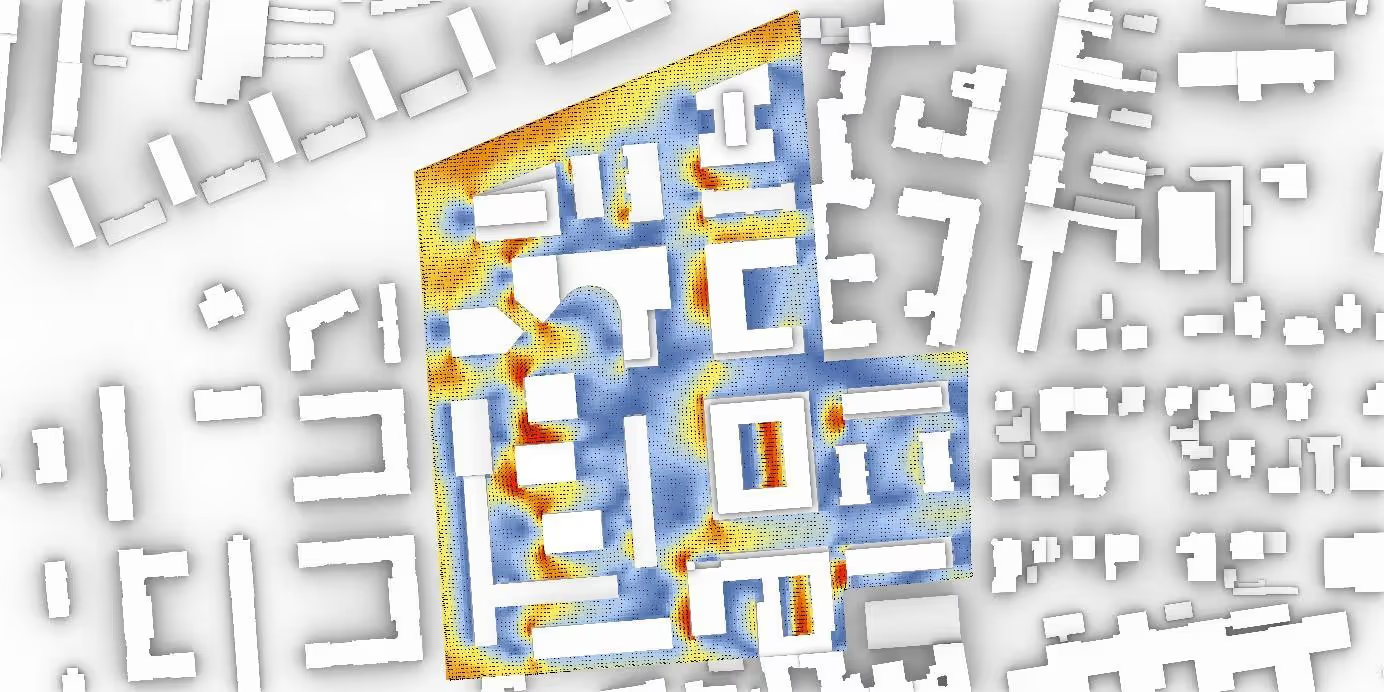

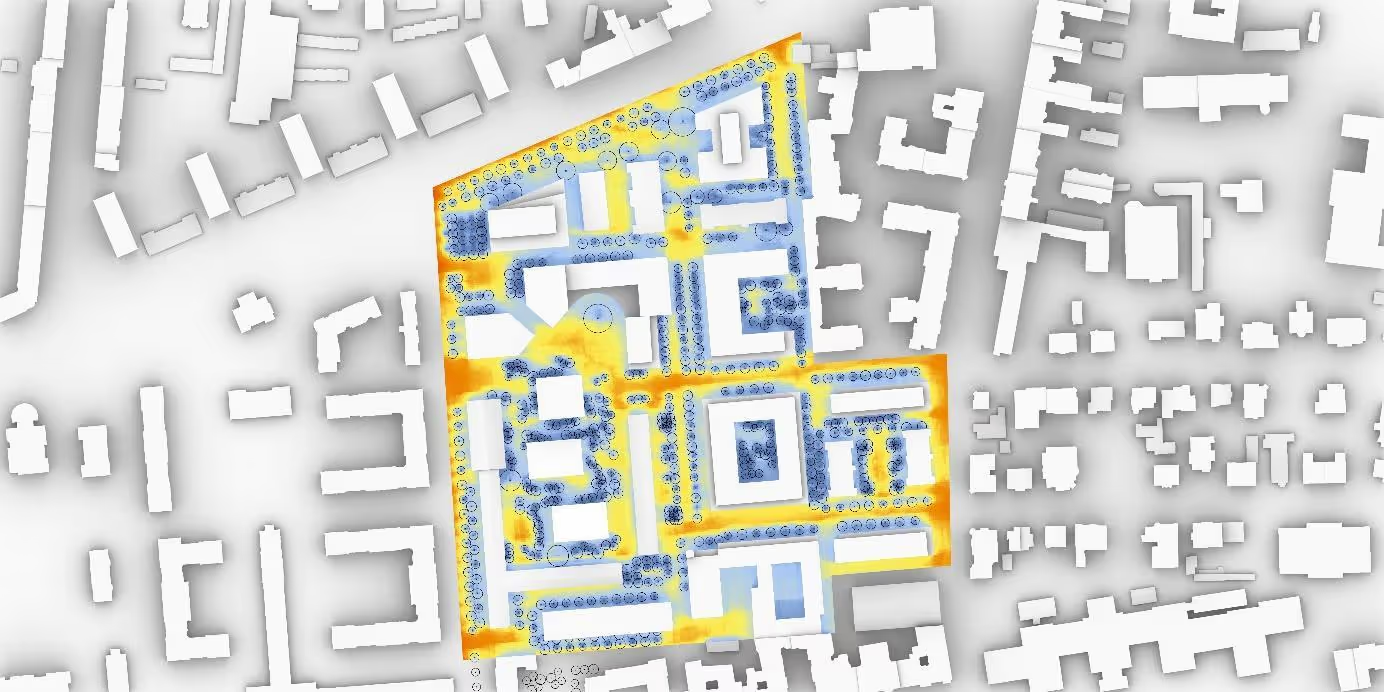

Projektowanie parametryczne w służbie zrównoważonego rozwoju

Te filozoficzne założenia stały się fundamentem dla współczesnego projektowania parametrycznego, które – poprzez wykorzystanie zaawansowanych narzędzi komputerowych – umożliwia eksplorowanie nieskończonej liczby wariantów projektowych, najlepiej odpowiadających określonym kryteriom wydajności. Coraz nowsze technologie cyfrowe pozwoliły zmaterializować te zależności w postaci algorytmów, które odbywają się niejako „w tle podświadomości” doświadczonych projektantów. Wpłynęły również na dalszy rozwój badań skoncentrowanych na wpływie konkretnych analizowanych parametrów wejściowych na efekt końcowy. Należy zaznaczyć, że dzięki możliwości przeprowadzenia większej liczby wirtualnych testów, jesteśmy w stanie szybciej wyeliminować rozwiązania szczególnie niekorzystne. Początkowo tzw. architekturę parametryczną charakteryzowała złożoność geometrii, która nie obowiązywała jako standard w przypadku klasycznego warsztatu projektanta. Stanowiło to pewien rodzaj manifestu możliwości wykorzystania nowych technologii. Widać to zwłaszcza w pierwszych projektach Zahy Hadid, gdzie dominowały falujące, dynamiczne formy, zaś procesom tworzenia wnętrza budynków towarzyszyły nowe technologie oraz narzędzia projektowania parametrycznego. Natomiast zauważalne korzyści eksploracji idei projektowania parametrycznego i tzw. data driven design przynoszą w procesie poszukiwania najlepsze i zarazem j optymalne rozwiązania w danym kontekście. Jednym z kluczowych aspektów, na których skupia się współczesne projektowanie, jest analiza wpływu ukształtowania bryły budynku, tektoniki fasady i jej orientacji względem stron świata na efektywność energetyczną. Poprzez algorytmiczne modelowanie różnych wariantów projektowych, architekci mogą już na wczesnym etapie identyfikować optymalne rozwiązania, które będą miały bezpośredni wpływ na zmniejszenie zapotrzebowania energii do ogrzewania, chłodzenia czy oświetlenia budynku. Szczególnie sugestywnym wizualnie przykładem wykorzystania projektowania opartego na danych w praktyce jest projektowanie fasad budynków. Mogą być one kształtowane w procesie projektowym tak, aby maksymalizować naturalne oświetlenie wnętrz, jednocześnie minimalizując nadmierną ekspozycję na słońce i związane z tym zapotrzebowanie na chłodzenie. Algorytmy pomagają wizualizować wpływ projektowanych form na ogólny bilans energetyczny budynku. Integracja komponentów modelu BIM (z odpowiednio przygotowanym algorytmem) stwarza niesamowite możliwości analizy orientacji fasady względem stron świata, a także wpływu na kształt i usytuowanie, np. elementów zacieniających czy paneli fotowoltaicznych na parametry wewnętrzne budynku. W poniżej prezentowanym przykładzie poddano analizie wpływ ukształtowania elementów fasadowych (w tym także zacieniających) na redukcję zużycia energii w ogólnym bilansie energetycznym budynku.

Współczesne możliwości: BIM

i projektowane oparte na danych optymalizacji energetycznej w nowoczesnym budownictwie Współcześnie optymalizacja zużycia surowców, energii i śladu węglowego staje się priorytetem odzwierciedlającym globalne dążenie do zrównoważonego rozwoju i minimalizacji negatywnego wpływu człowieka na planetę. Rozwój technologii i metodyki BIM (Building Information Modeling) umożliwił dalsze rozszerzenie warsztatu kompleksowej analizy i kontroli nawet bardzo złożonych kryteriów projektowych i tym samym jeszcze dokładniejszą weryfikację i modelowanie wpływu budynków na środowisko jeszcze na etapie projektowym. Dzięki temu architekci oraz inżynierowie mogą w jeszcze bardziej precyzyjny sposób przewidywać i optymalizować zużycie energii, wpływając tym samym na redukcję śladu węglowego oraz kosztów eksploatacyjnych budynków. Technologia BIM (Building Information Modeling) zrewolucjonizowała sposób, w jaki architekci i inżynierowie podchodzą do projektowania i zarządzania projektami budowlanymi. BIM to nie tylko oprogramowanie, lecz także proces umożliwiający tworzenie cyfrowych reprezentacji fizycznych oraz funkcjonalnych cech obiektu budowlanego. Metodyka BIM skupia się również na modelowaniu i wykorzystaniu informacji o budowli przez wszystkich użytkowników (zarówno procesu projektowego, jak i inwestycyjnego, z uwzględnieniem całego cyklu jego życia). Można zatem łatwo sobie wyobrazić, że integracja idei projektowania parametrycznego z metodyką i narzędziami BIM stanowi podejście, które pozwoli w sposób iteracyjny przeprowadzać cykle analiz z wykorzystaniem algorytmów. Włączając analizy wspomagane algorytmami i sterując kluczowymi parametrami np. bryły budynku, usytuowania względem stron świata, ukształtowaniem elementów fasadowych projektanci mogą – na etapie projektowym – dokonywać symulacji ukazującej, w jaki sposób zmiana analizowanych parametrów rzutuje np. na efektywność energetyczną, optymalizację wykorzystania światła dziennego czy zużycie surowców i tym samym ślad węglowy budynku. Projektanci oraz inwestorzy, dysponując wynikami kompleksowych analiz, wchodzą na zupełnie inny poziom możliwości predykcji różnych aspektów inwestycji i tym samym są w stanie podejmować bardziej świadome decyzje.

Digital Twin i analizy danych o budynku w czasie rzeczywistym

Obecnie dużą nadzieję pokłada się w analizach danych w czasie rzeczywistym. Tego typu idee wdrażane są wraz z koncepcją tzw. Digital Twin, czyli cyfrowego odpowiednika budynku stosowanego do zarządzania obiektem. „Cyfrowy bliźniak” – wraz z ideą zarządzania cyklem życia budynku – stanowi końcową, najbardziej zaawansowaną fazę wykorzystania modeli i metodyki BIM w procesie inwestycyjnym i w cyklu życia budynku. Odpowiednio przygotowany, cyfrowy odpowiednik rzeczywistej budowli, spięty z systemem BMS, pozwala na sprawne zarządzanie utrzymaniem budynku. Informacje uzyskane z modeli BIM, jak i systemu BMS stanowią źródło danych do analiz w czasie rzeczywistym, wyciągania wniosków faktycznym funkcjonowaniu budynku i przeprowadzaniu dodatkowych symulacji i predykcji pozwalających na optymalniejsze wykorzystanie zasobów budynku. Mogą one być używane np. do bardziej efektywnego zarządzania zużyciem energii w budynku i tym samym stanowić źródło wiedzy wykorzystywanej do tworzenia corocznych raportów ESG. Tego typu model „żyje” razem z budynkiem. W przypadku konieczności remontu czy też przebudowy mamy dostęp do wszystkich niezbędnych informacji, pozwalających sprawnie przeprowadzić proces projektowy, a następnie przeanalizować wpływ projektowanej zmiany na cały system. Jednym z przykładów budynku tego typu jest The Edge w Amsterdamie, zaprojektowany przez pracownię PLP Architecture, często uznawany za jeden z najbardziej zrównoważonych i inteligentnych budynków biurowych na świecie. Dzięki zastosowaniu technologii BIM i zaawansowanym rozwiązaniom projektowania parametrycznego budynek ten osiąga niezwykle niskie zużycie energii. Zastosowanie optymalizacji energetycznej dotyczy zarówno zewnętrznych, jak i wewnętrznych aspektów budynku. Fasada budynku wykorzystuje specjalnie zaprojektowane panele słoneczne, które maksymalizują produkcję energii, jednocześnie umożliwiając naturalne oświetlenie wnętrz. System zarządzania budynkiem (BMS) integruje wszystkie instalacje, optymalizując zużycie energii w czasie rzeczywistym.

Najnowsze wydanie!

Komentarz